Как с помощью 2х терабайт данных и 50 чашек кофе сэкономить компании несколько млрд рублей

В мире существует огромное количество методологий и инструментов для оптимизации бизнес процессов. Какие-то из них основаны на использовании технологий BPM, другие же за основу берут интервьюирование клиента. Я же расскажу о подходе, основанном на данных пользовательского опыта.

Всем привет, меня зовут Сергей, и на самом деле кофе было выпито намного больше чем 50 чашек, но речь пойдет не об этом.

Я работаю техническим директором в «ОСМ Групп», до этого я несколько лет был консультантом и архитектором SAP, из них какое-то время занимался исследованием и оптимизацией бизнес-процессов. Согласитесь, если бы я написал 10 лет и 4 года, предыдущая фраза стала бы более ценной. К чему это я? А к тому, что данные очень важны в нашей жизни, но еще более важно правильно эти данные использовать. Далее речь пойдет о том, какие данные нужны, и что с ними сделать для того, чтобы оптимизировать бизнес-процессы клиента, а также я поделюсь некоторыми нюансами и “граблями”, с которыми мы познакомились, когда делали подобные анализы.

Все начинается с гипотез

Гипотеза в нашем понимании - это предположение, что в какой-то части бизнес-процесса имеются точки для оптимизации. Гипотезы обязательно должны быть правильно сформулированы, т.к. от верной формулировки зависит многое, например, понимание какие данные искать, в каких системах и т.д.

Например, правильная гипотеза может звучать так:

“В системе SAP присутствуют учетные записи пользователей с присвоением избыточных полномочий” - сразу ясно, надо брать данные из SAP по присвоению ролей и полномочий.

А неправильная так:

“У клиента есть неактивные сотрудники” - в какой системе, какие данные для этого нужны - не совсем понятно.

Кстати, чем больше гипотез в самом начале - тем лучше, иногда даже самые “дикие” на первый взгляд идеи могут оказаться верными и принести эффект.

Еще, благодаря нашему многолетнему опыту работы с пользователями различных систем (SAP, Oracle, 1C и др.), мы знаем и понимаем, где основные “боли” и проблемы в бизнес-процессах клиента. Так что большинство гипотез у нас уже сформулированы.

Следующим этапом идет сбор и предобработка данных

Оказывается собрать данные - очень нетривиальная задача. Во первых - надо понимать, какие данные нужны, а во-вторых – где, собственно, эти данные найти.

В качестве данных могут выступать различные отчеты и выгрузки из разных систем, логи, журналы, базы данных, инструкции и т.д. Но одно дело собрать данные, так их еще надо нормализовать, очистить - в общем, как следует подготовить для дальнейшего анализа. На этом этапе часто выясняется, что каких-то данных не хватает, или же, что у клиента имеются проблемы с хранением данных. Как пример, в SAP есть замечательный отчет SM20, а многие клиенты записывают далеко не все данные в этом отчете, и приходится активировать запись всех данных и собирать в течение периода времени, достаточного для получения репрезентативной выборки.

Кстати отсутствие каких-либо данных тоже может являться симптомом наличия проблем в бизнес-процессах.

Далее - сам анализ

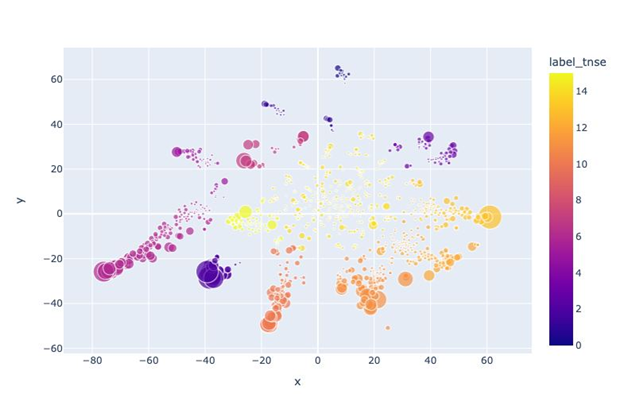

Итак, данные собраны и качественно подготовлены. Теперь вступает в бой тяжелая артиллерия, а именно команда датасаентистов, математиков, аналитиков, бизнес экспертов и других умных людей. Для анализа мы используем различные алгоритмы работы с большими данными, строим модели машинного обучения, а также старую добрую математическую статистику.

Тут есть интересный момент, что у разных клиентов приходится использовать разные алгоритмы, причем выбор алгоритма происходит только в ходе анализа, когда получаются первичные результаты. Тут очень много переменных - численность персонала, качество и объем данных, температура в помещении и т.д.

А еще по ходу анализа обнаруживаются новые гипотезы, что тоже очень полезно.По итогам анализа удается подтвердить некоторые гипотезы (или опровергнуть).

После анализа приходим к экономике

Собственно то, ради чего делается сам анализ - это нахождение экономических эффектов во время поиска неэффективных мест в бизнес-процессах. Тут тоже нужны определенные данные: это может быть средняя текучка персонала, стоимость минуты рабочего времени сотрудника, сумма штрафов за несоблюдение условий договора и т.д. - все, что может в перспективе принести деньги (или не позволить эти деньги потерять).

Конечно же, найденные потенциальные эффекты требуют подтверждения со стороны бизнеса. Чаще всего в этом месте сумма эффектов сильно снижается, т.к. оказывается, что некоторые эффекты просто не актуальны или для их достижения потребуется потратить больше средств. Бывает даже так, что мы находим эффект, приносим его бизнесу, а они говорят, что мы не будем это оптимизировать, т.к. это “политика компании” или действует принцип “работает - не трогай”.

Но в любом случае, итоговые результаты впечатляют. Как пример, для компании численностью около 15 тысяч сотрудников при анализе сквозного процесса закупок найдены эффекты на сумму в несколько млрд рублей. Далее - судите сами.

В заключение

На самом деле я описал далеко не все нюансы и подводные камни, с которыми можно столкнуться при таком подходе. Быть может, мы и сами еще не все обнаружили, но активно ищем.

Также я хочу пригласить вас на мастер-класс «Business process mining: с чего начать, подводные камни, эффекты» 25 мая 2023 года, в рамках которые мы с Егором Ведерниковым расскажем, как с помощью инструментов BIG DATA, машинного обучения, анализа данных опыта пользователей в части выполнения операций в системах, оптимизировать бизнес-процессы предприятия и значительно повысить бизнес-эффекты от ИТ-систем.

Сергей Воронов

Об авторе: более 5-ти лет является архитектором сквозных бизнес-процессов. Обладает глубоким знанием процессов P2P и смежных с ними. Реализовал более чем 5 проектов по глубокой аналитике пользователей, бизнес-процессов и ролевых моделей. Является владельцем продукта и архитектором ОСМ Аналитика.